即可将网页分享至朋友圈

近期,计算机科学与工程学院(网络空间安全学院)吴立军教授指导的2019级博士生李志圆在本学科领域顶级期刊Nerual Networks和顶级会议AAAI上,围绕多智能体强化学习发表了系列研究成果。

在中国科学院一区国际著名期刊ELSEVIER Neural Networks上发表的题为“Coordination as inference in multi-agent reinforcement learning”的研究论文,对分散式多智能体强化学习提供了新的思路和可能性。

集中训练和分散执行(CTDE)范式在最近几年取得了巨大进展,其中Critic允许在训练阶段访问全局信息,同时使用分散方式执行仅具有局部信息的学习策略。尽管CTDE取得了很大进展,但其可能会遭受集中-分散不匹配(CDM)的问题:一个智能体策略的次优性可能会通过集中的Critic影响其他智能体的策略学习。与集中式学习相比,最接近人类合作方式的模型是完全分散的,即独立学习(IL)。然而,在智能体通过IL进行协作之前,仍然有两个问题需要解决:(1)智能体如何意识到其他智能体的存在,(2)如何协调其他智能体以改进IL下的联合策略。

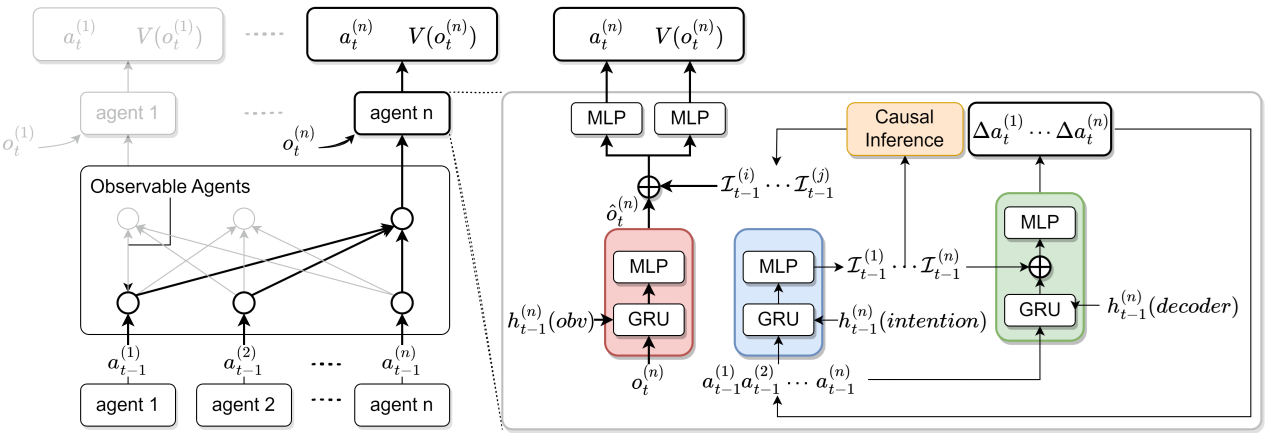

文章提出了一种基于推理的协调MARL方法:Deep Motor System(DMS)。 DMS首先提出了个体意图推理的想法,其中允许智能体从环境中将其他智能体解耦。接着,引入因果推理以通过推断每个智能体对其他人行为的影响来增强协调。本成果提供了一种独立学习的解决方案,能够有效提高可扩展性和灵活性,在未来的实际部署中具有前景。

全文链接:https://www.sciencedirect.com/science/article/pii/S0893608024000157

在CCF-A计算机国际顶级会议The 38th Annual AAAI Conference on Artificial Intelligence(AAAI-24)上发表的题为“Backpropagation Through Agents”的合作式多智能体强化学习的研究论文。该工作为李志圆赴芬兰阿尔托大学联合培养期间完成。电子科技大学计算机科学与工程学院为论文第一单位。

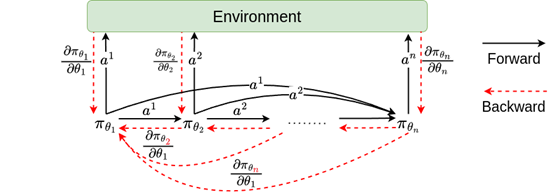

多智能体强化学习(MARL)中的一个基本挑战是在一个随着智能体数量呈指数增长的极其庞大的搜索空间中学习联合策略。此外,完全分散的策略因子化显著限制了搜索空间,可能导致次优策略的产生。相比之下,自回归联合策略可以通过将联合策略因子化为一系列条件个体策略的积来表示更丰富的联合策略类别。虽然这种因子化在顺序执行中明确地引入了智能体之间的行动依赖关系,但在学习过程中并没有充分利用这种依赖。特别是,后续智能体没有向前驱智能体提供关于其决策的反馈。文章提出了一个新的框架——智能体间反向传播(BPTA),直接考虑了智能体自身策略更新和其相关对应智能体的学习。这是通过动作链传播反馈来实现的。借助提出的框架,文章提出的双向近端策略优化(BPPO)优于最先进的方法,进一步推动多智能体强化学习在实际应用的落地。

全文链接:https://arxiv.org/abs/2401.12574

编辑:李果 / 审核:李果 / 发布:陈伟