即可将网页分享至朋友圈

近日,生命科学与技术学院neuSCAN团队在人工智能及机器学习领域国际著名期刊《IEEE神经网络与学习系统汇刊》(IEEE Transactions on Neural Networks and Learning Systems, IEEE TNNLS)发表题为Mask-guided Vision Transformer for Few-Shot Learning(基于掩膜引导的视觉Transformer的少样本学习)的研究论文。团队2020级硕士研究生陈钰中为论文第一作者,蒋希研究员为论文唯一通讯作者,电子科技大学为论文第一署名单位。该论文得到了国家自然科学基金、四川省自然科学基金等支持。

近年来,得益于Transfromer架构模型在自然语言处理领域的成功,越来越多的学者开始将Transfromer架构模型引入计算机视觉领域并获得与卷积神经网络相媲美甚至优于一般卷积神经网络的性能。视觉Transformer架构模型往往需要较高的数据量进行模型的训练。但在一些应用场景中,标注数据难获取,训练样本数量低。因此,如何使用少样本数据有效地进行Transformer架构模型的训练至关重要。

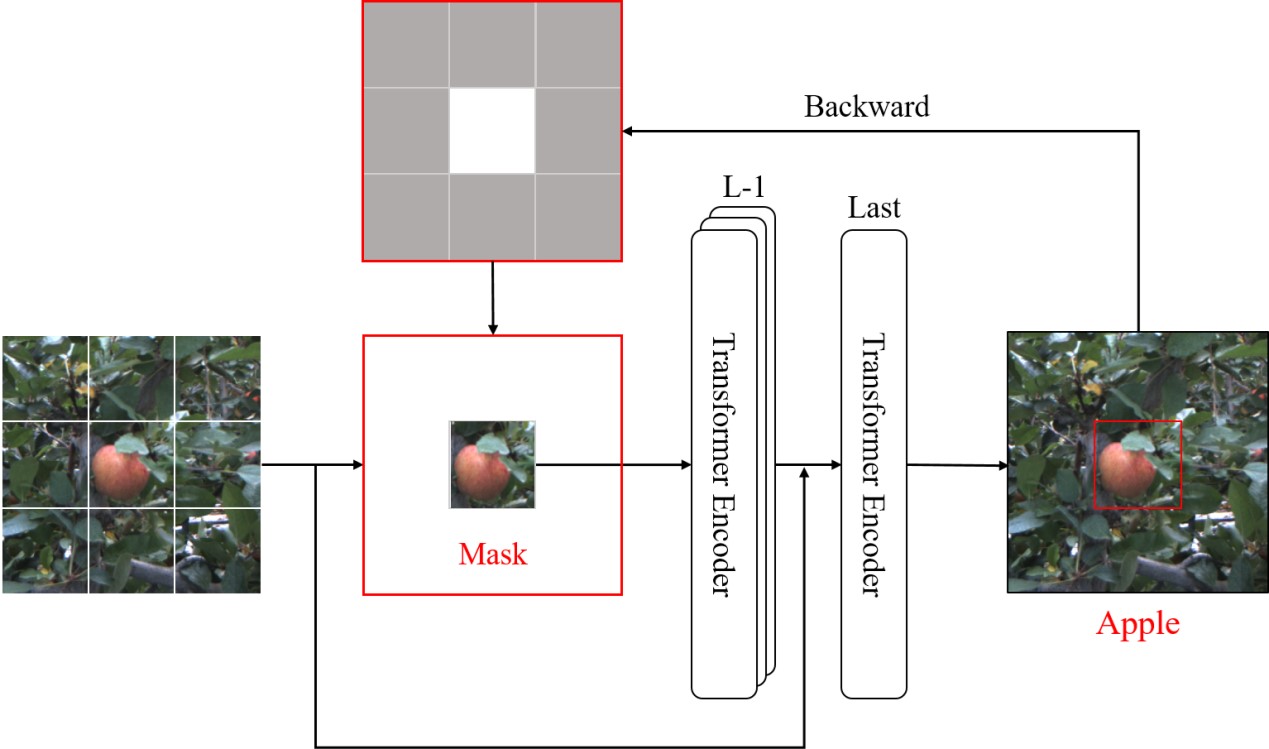

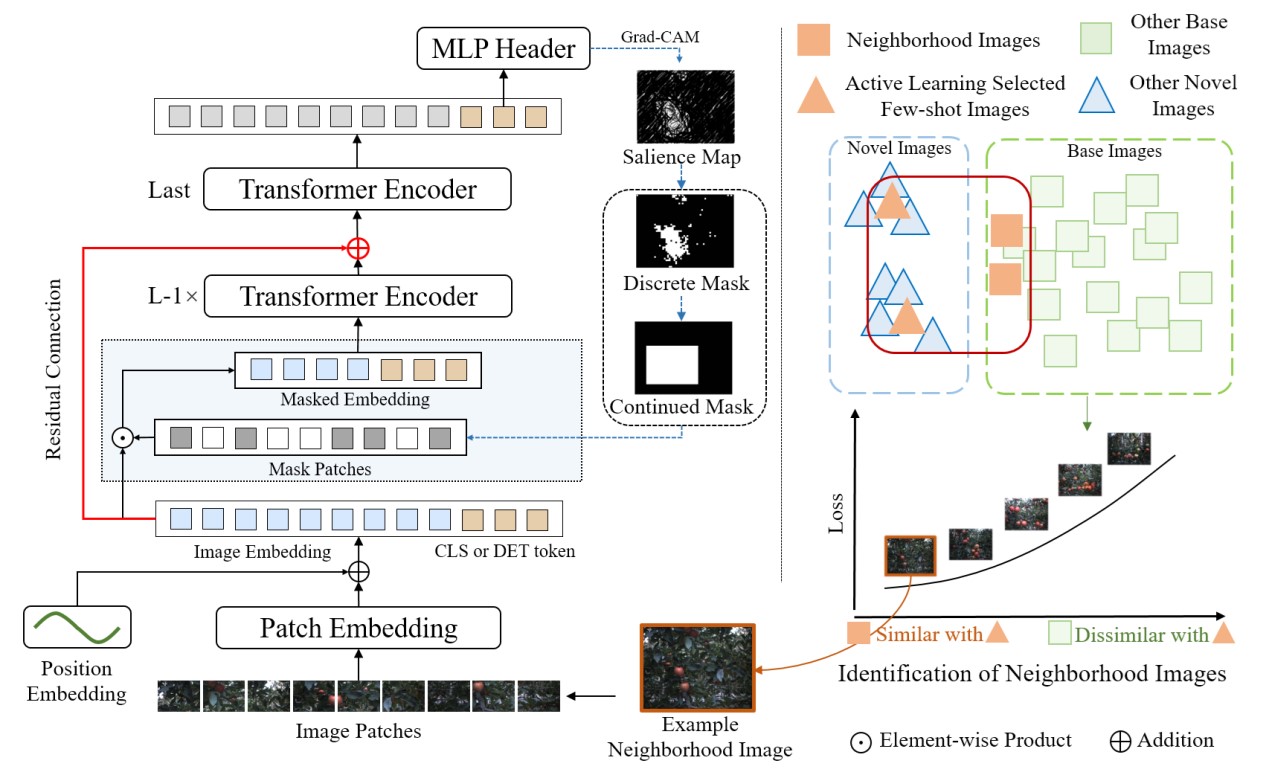

为了解决上述问题,本论文提出了一种基于掩膜引导的视觉Transformer架构模型用于少样本学习任务。如图一所示,本论文的核心思想是提取出任务相关的区域掩膜(本论文使用Grad-CAM,gradient-weighted class activation mapping方法提取掩膜),并对输入图像进行掩盖操作,使模型关注于任务相关特征,降低模型的捷径学习(shortcut learning),从而提高视觉Transformer的少样本学习能力。其具体流程如图二所示,基于掩膜引导的视觉Transformer架构方法适用于目标检测任务和分类任务。实验结果表明,该方法有效提高了视觉Transformer的少样本学习能力,为其在医疗影像病灶检测和疾病识别等应用场景打下良好基础。

图一 任务相关区域的掩膜获取及其对输入图像的掩盖操作

图二 基于掩膜引导视觉Transformer的少样本学习的整体流程框架

IEEE Transactions on Neural Networks and Learning Systems为中国科学院大类一区top期刊,主要发表有关神经网络和相关学习系统的理论、设计和应用的技术文章。CiteScore排名计算机科学大类计算机科学应用子类所有期刊8/792,计算机科学大类计算机网络与通信子类所有期刊5/379,计算机科学大类软件子类所有期刊11/404,以及人工智能子类所有期刊10/301。

蒋希研究员是电子科技大学“百人计划”入选者,博士生导师,四川省学术和技术带头人后备人选。研究方向为医学影像人工智能和类脑人工智能。2019年“美国李氏基金会杰出成就奖之学术发展奖”唯一获奖者。曾获2021年医学影像分析国际会议MLMI最佳论文奖、2016年国家优秀自费留学生奖等荣誉。担任医学影像分析顶级会议MICCAI 2022-2023年领域主席及多个国际期刊编委。发表第一或通讯作者(含共同)论文38篇,Google学术引用3960余次,h指数34,i10指数89。主持3项国家自然科学基金。

编辑:罗莎 / 审核:李果 / 发布:陈伟