即可将网页分享至朋友圈

近日,信息与通信工程学院物联网智能芯片与系统团队2021级博士研究生韦仕才在面向开放环境的多模态表征学习方向取得重要研究进展,以第一作者身份连续在多个国际顶级会议和期刊发表论文,包括一篇 IEEE Transactions on Multimedia (IEEE TMM),两篇IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR2023,CVPR2024), 一篇European Conference on Computer Vision (ECCV2024) 。指导老师为骆春波教授,电子科技大学为唯一署名和通讯单位。研究围绕模态受限和模态缺失问题,设计了新颖知识嵌入的框架来辅助提高模型性能,为了提高跨模态跨结构场景下异质知识迁移效果,设计了尺度解耦蒸馏算法,最后从理论上对模态受限和缺失问题进行深入分析,首次提出了不需要知识嵌入辅助便可以保留全量多模态信息的框架。

CVPR和ECCV均为人工智能领域顶会,其中CVPR在最新Google学术排名中位居第二,仅次于Nature。IEEE TMM为中科院一区期刊,该期刊主要刊发多媒体技术及其应用相关的最新研究成果,属于多媒体领域最具影响力的顶级期刊。

论文1 “Privileged Modality Learning via Multimodal Hallucination”发表在IEEE TMM上,用于解决模态受限场景的多模态表征学习问题,弥合模态完整的理想训练场景与模态不完整的实际部署场景之间的差异。已有研究通常利用额外的模型对缺失模态进行重建,然后和可获取模态训练的模型进行后融合来解决问题。但是这样的处理忽略了跨模态交互信息的学习,导致最终的机器学习模型在模态缺失部署场景的性能不佳。

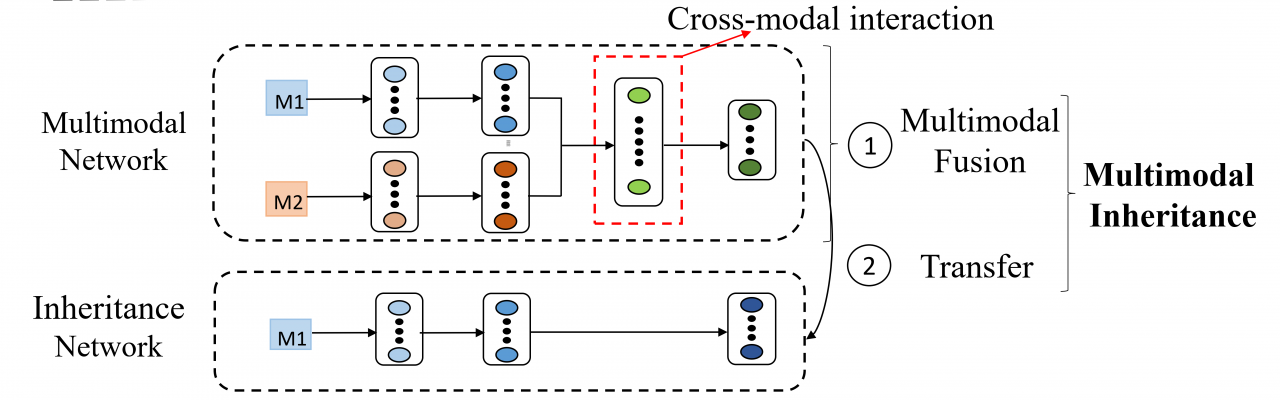

图表 1:TMM提出的多模态重建框架示意图

本文提出了多模态重建框架指导重建网络直接从多模态网络中学习模态共享信息。相比于传统先重建再融合的模态重建框架,本文的重建网络可获取更充分的跨模态交互信息,同时提高了模型对多个受限模态的可扩展性。与传统的模态重建方法相比,该多模态重建框架也引入了额外的架构和信息差距,提高了知识迁移的难度。为此,我们进一步设计异构蒸馏方法用于辅助多模态幻觉框架的训练。实验表明,本文所提出的多模态框架可以克服多场景中模态输入不完整的问题,并相比于已有方法取得了更优的性能表现。

论文2 “MMANet: Margin-aware Distillation and Modality-aware Regularization for Incomplete Multimodal Learning” 发表在CVPR2023上,用于解决模态缺失场景下的多模态表征学习问题。不同于模态受限场景,模态缺失场景下的缺失模态因为故障等原因往往是不可预测的,也因此更难以处理。为此已有研究提出让模型在训练阶段接触到所有的模态组合,从而学习到它们之间的不变特征。这类方法逻辑上较为简单直接,但是由于仅关注于模态间不变特征而忽略了不同模态的私有特征,导致了多模态模型对不同模态组合的优化不足问题。

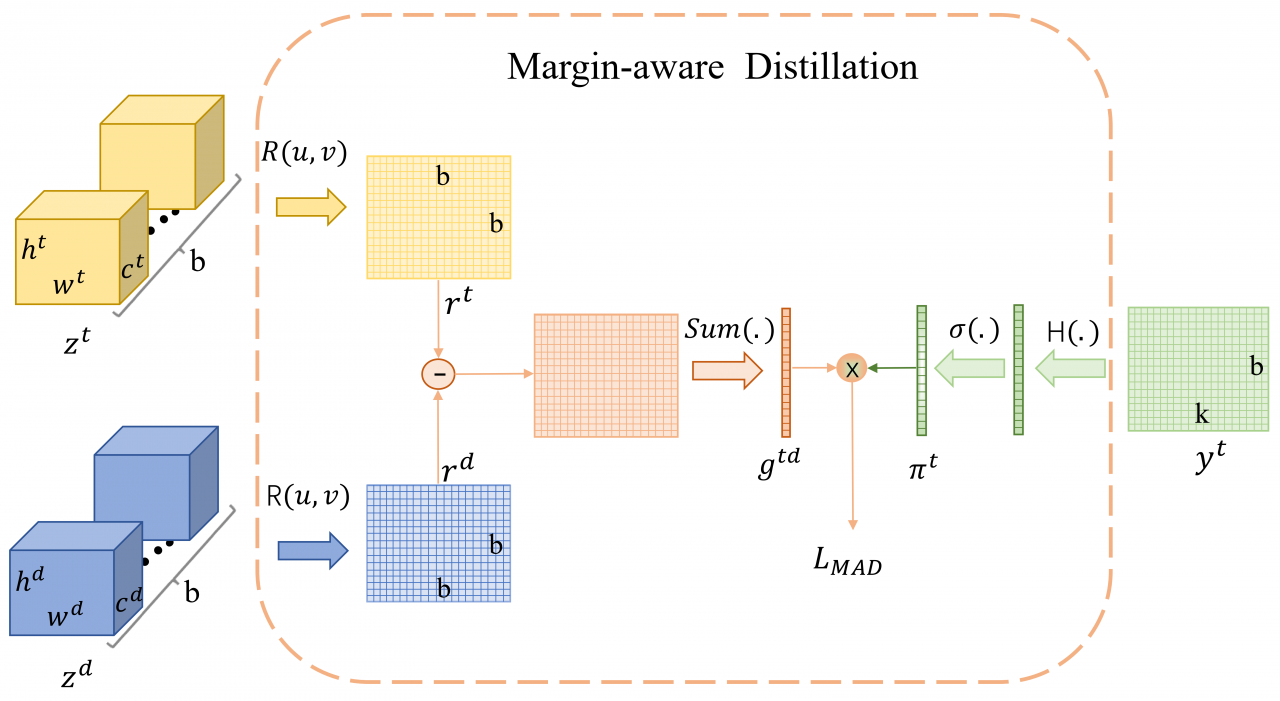

本文提出了基于模态私有知识嵌入的不完整多模态表征学习框架,通过引入采用完整的多模态数据预训练的教师网络,指导部署网络向教师网络学习从而获取全面的多模态知识,使得部署网络具有鲁棒性的同时,增强了对所有单模态的表征能力。为了引导部署模型更多关注于所需要的模态私有信息,本文进一步提出了一种新颖的边缘感知蒸馏(MAD)方法(见图2)。MAD 测量类边界并引导部署模型更多地关注其附近的样本,鼓励部署网络从教师网络继承经过模态互补优化的类间边界并学习模态私有特征。实验结果证明,所提出的框架在处理各种不同类型的缺失和不同的任务上都实现了最优的性能。

图表 2:所提出的边缘感知蒸馏方法(MAD)的示意图

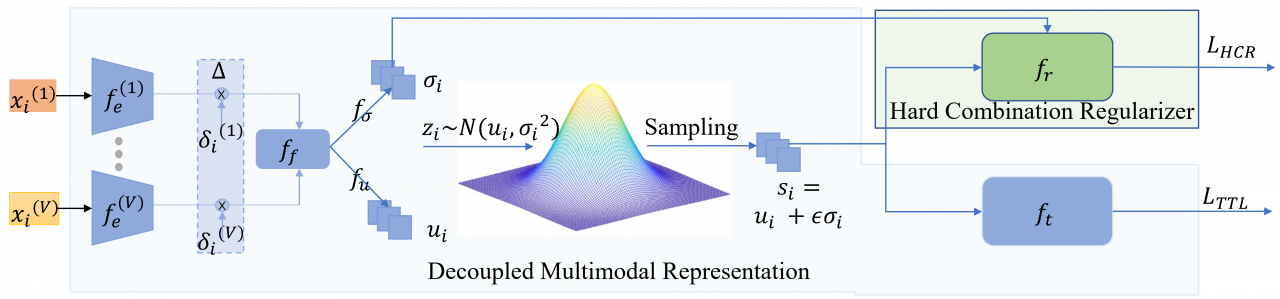

论文3 “Robust Multimodal Learning via Representation Decoupling” (ECCV2024录用)从理论上分析了解决模态缺失场景下的多模态表征学习问题。本文首次揭示了已有不完整多模态学习方法的类内表征方向约束问题,分析了其对机器学习模型在不同模态组合表征方面的具体限制。为此我们通过解耦训练表征和推理表征,提出了一个解耦多模态表征框架DMRNet (见图3)。DMRNet学习每个模态组合输入的分布,采样该分布的特征向量用于计算任务损失,然后将该分布的平均值作为用于推理的特征向量。因此,由损失最小化传回的方向约束被随机采样操作弱化,使模型能够为每个模态组合学习非平行推理特征,提高了模型的表征能力。相比于已有的基于知识嵌入的方法,所提出的框架不需要复杂的知识蒸馏过程,并且可以处理训练过程中的数据缺失问题,具有更广泛的应用场景。实验表明,所提出的DMRNet明显优于目前已有的方法。

图表 3:所提出的解耦多模态表征框架的示意图

论文4 “Scale Decoupled Distillation” 发表在CVPR2024上,用于解决跨模态异构知识迁移问题。知识蒸馏是知识迁移的常见手段,近年来基于Logit的知识蒸馏因其高效和普适的特点在异构知识迁移研究中受到越来越多的关注。然而与传统的基于特征的蒸馏相比,它的性能往往较差。

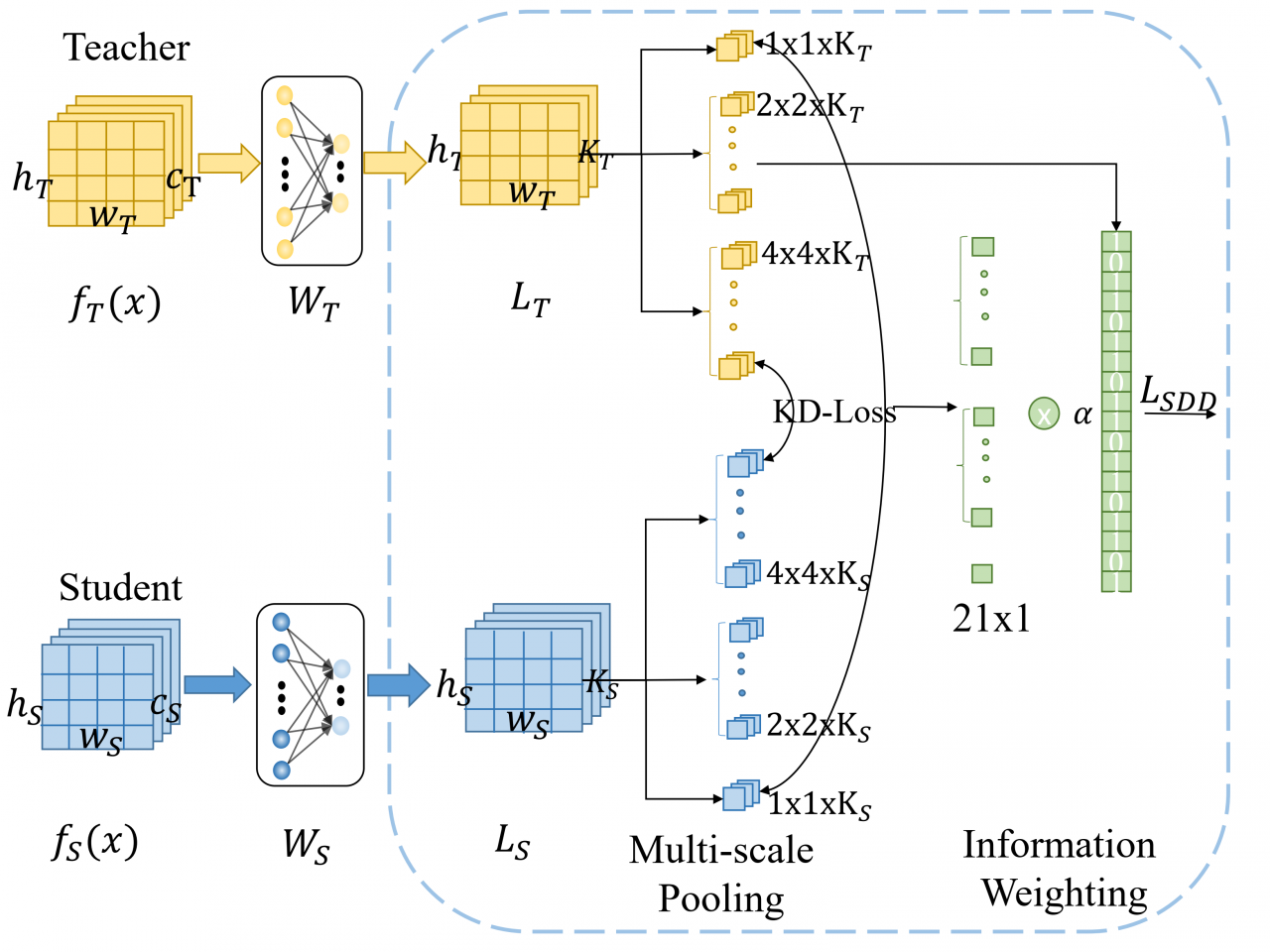

本文揭示了基于Logit蒸馏中多类别知识的经典耦合问题,分析了其阻碍学生模型从模糊样本中继承准确语义信息的挑战。为此,我们提出了一种尺度解耦蒸馏(SDD)方法,用于增强基于Logit的知识蒸馏。该方法将全局Logit响应输出解耦为多个局部响应输出,并为它们建立蒸馏通道,帮助学生模型挖掘和继承细粒度和无歧义的Logit知识。解耦后的知识进一步分为传输语义信息的一致项和样本歧义的互补项,通过增加互补部分的权重,本文的方法可引导学生模型更多地关注模糊样本,从而提高学习的效果。实验证明,该尺度解耦蒸馏方法可显著提升“异构师生模型对”的知识蒸馏性能。

图表 4:所提出的尺度解耦知识蒸馏的框架示意图

参考文献

1. Privileged modality learning via multimodal hallucination,

https://ieeexplore.ieee.org/abstract/document/10146467/

2. MMANet: Margin-aware distillation and modality-aware regularization for incomplete multimodal learning

3. Robust Multimodal Learning via Representation Decoupling

https://arxiv.org/abs/2407.04458

4. Scaled Decoupled Distillation

编辑:刘瑶 / 审核:罗莎 / 发布:李果