即可将网页分享至朋友圈

近日,2025 IEEE国际计算机视觉与模式识别会议(IEEE Conference on Computer Vision and Pattern Recognition,简称CVPR)官方公布论文收录结果。据CVPR官网显示,本届CVPR收到了创新高的13008份论文(比CVPR2024增加了12.8%),共录用了2878篇论文,接收率为22.1%。这些被录取的最新科研成果涵盖了计算机视觉领域各项前沿工作。计算机(网安)学院数据智能团队(DIG)2022级博士研究生吴海峰、2023级博士研究生李巍炜、2023级博士研究生张乐恒、2024级博士研究生龙伟、2023级硕士研究生杨宇航和2021级博士研究生邓金红(共同一作)、2023级硕士研究生卢景博撰写的6篇论文被此次会议接收。

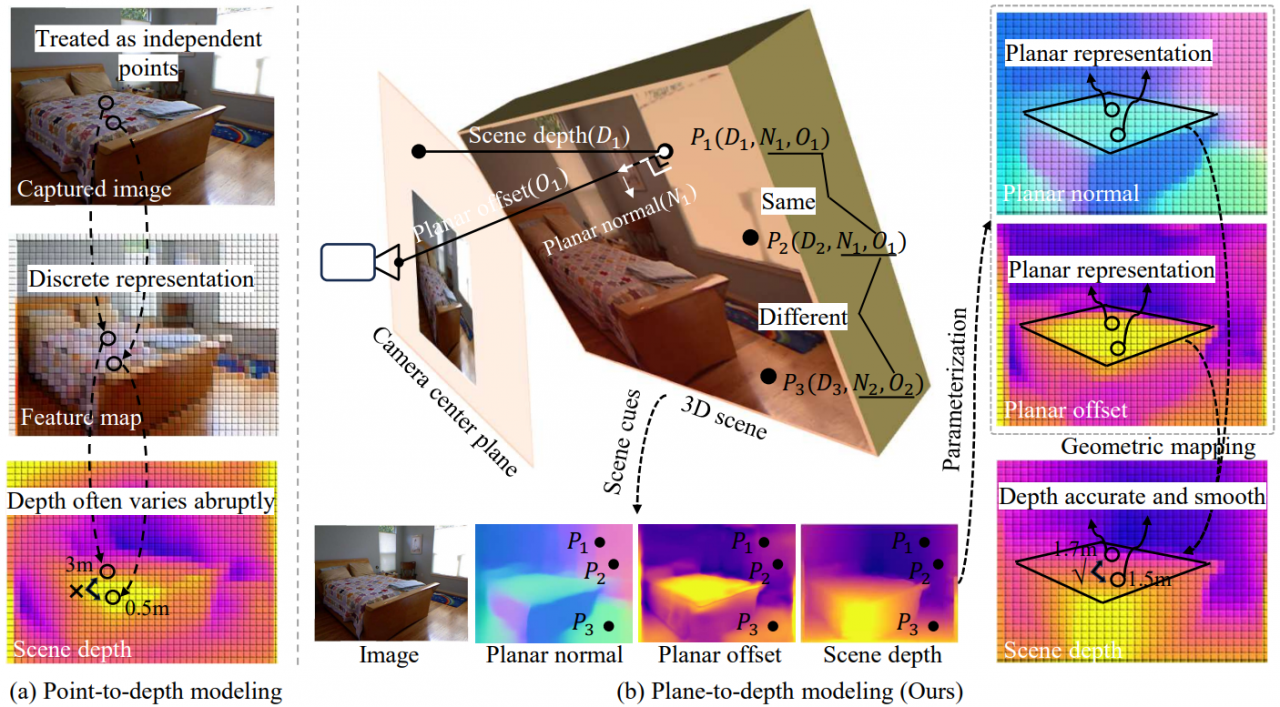

图1 论文《GeoDepth: From Point-to-Depth to Plane-to-Depth Modeling for Self-Supervised Monocular Depth Estimation》内容示意图

2022级博士生吴海峰以第一作者撰写的论文《GeoDepth: From Point-to-Depth to Plane-to-Depth Modeling for Self-Supervised Monocular Depth Estimation》(作者:吴海峰、顾舒航、段立新、李文【通讯作者】)发现了基于点表示的方法忽略了3D场景中的结构化信息,使预测的深度图中相邻像素的深度存在突然跳变,提出了基于平面表示的自监督深度估计方法。该方法将3D场景建模成以平面法线和平面偏移进行参数化的平面集合,并提出结构化平面生成模块和深度不连续性感知模块,确保平面集合的准确性,最终从精确的平面参数转换到深度。实验结果表明,该方法在室内和室外数据集上取得了不错的结果。

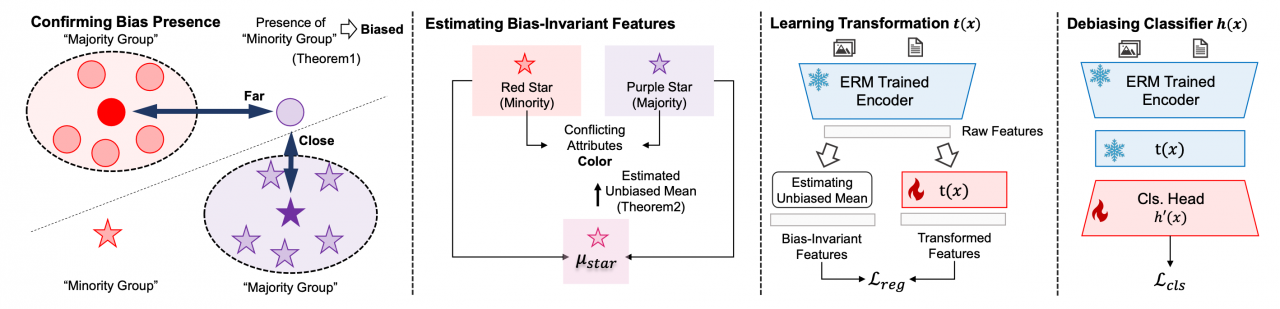

图2 论文《Let Samples Speak: Mitigating Spurious Correlation by Exploiting the Clusterness of Samples》内容示意图

2023级博士生李巍炜以第一作者撰写的论文《Let Samples Speak: Mitigating Spurious Correlation by Exploiting the Clusterness of Samples》(作者:李巍炜、刘俊灼、任媛媛、郑煜辰、刘亚豪、李文【通讯作者】) 在理论层面证明了深度神经网络的错误决策规则(比如使用发色分类性别)的源头——虚假特征往往在特征空间中呈现分散分布,并由此提出了一种面向数据的方法来识别、中和模型特征层中的虚假特征,减轻深度神经网络对虚假特征的依赖,从而消除模型的错误决策规则。该方法在多个图像、文本、医疗数据集上的最差组准确率与标准经验风险最小化 (ERM) 相比,提高了20%以上。

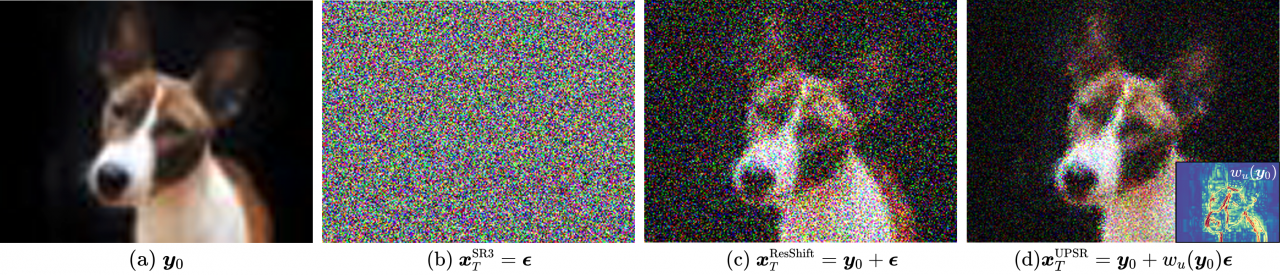

图3 论文《Uncertainty-guided Perturbation for Image Super-Resolution Diffusion Model》内容示意图

2023级博士生张乐恒以第一作者撰写的论文《Uncertainty-guided Perturbation for Image Super-Resolution Diffusion Model》(作者:张乐恒、游炜熠、施柯煊、顾舒航【通讯作者】)对现有的基于扩散模型的超分辨率方法进行了优化,从不确定性的角度将各向同性的扩散过程改为各向异性的过程。该方法仅在图像中不确定性高的部分(边缘、纹理等较难复原的部分)添加较大的噪声,而在不确定性低的部分(平滑区域等易于复原的部分)减少噪声强度,使得扩散过程更符合超分辨率任务的特性。实验结果表明,该方法在多个真实世界超分辨率数据集上取得了不错的成绩。

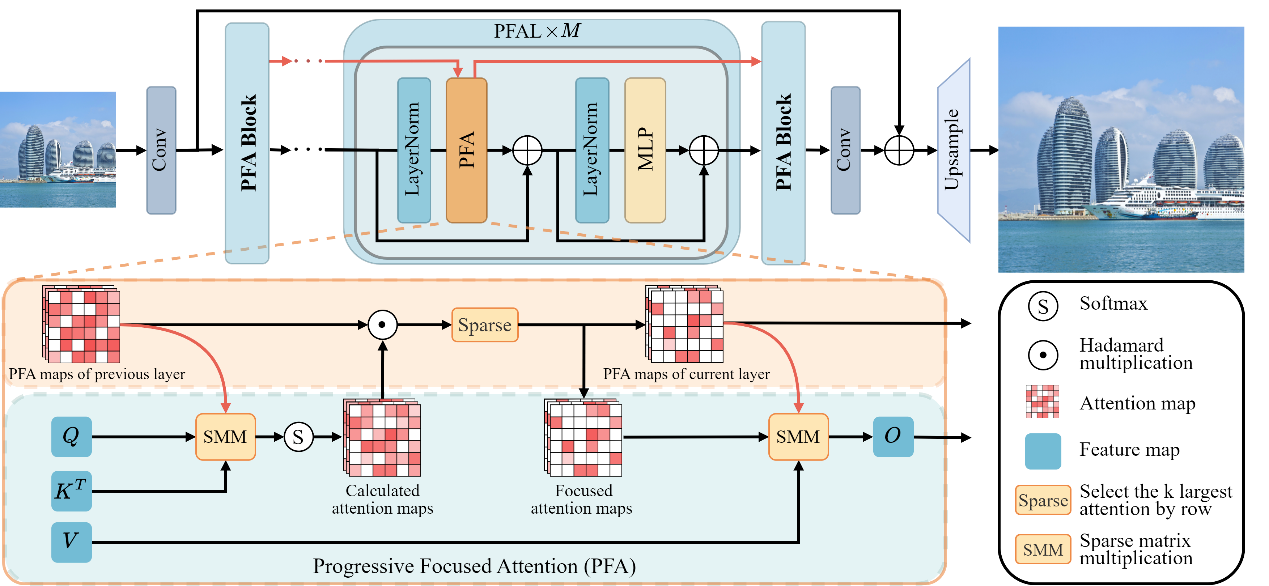

图4 论文《Progressive Focused Transformer for Single Image Super-Resolution》网络示意图

2024级博士生龙伟以第一作者撰写的论文《Progressive Focused Transformer for Single Image Super-Resolution》(作者:龙伟、周星宇、张乐恒、顾舒航【通讯作者】)。现有基于Transformer的超分辨率重建方法面临较高计算复杂度的问题,其根源在于现有注意力机制中存在大量与查询特征无关的冗余相似性计算,这不仅降低了模型的重建性能,还增加了显著的计算开销。为了解决这一问题,本文提出了一种高效的渐进聚焦型Transformer架构,该架构通过哈达玛乘积将网络中所有孤立的注意力图进行关联整合,从而使注意力资源集中分配到最关键的图像区域。该方法不仅能够精准捕获语义关联性强的相似特征,还能在相似性计算之前动态过滤冗余特征,从而显著降低整体计算成本。实验结果表明,该方法在多个图像超分辨率数据集上均取得了最先进的性能。

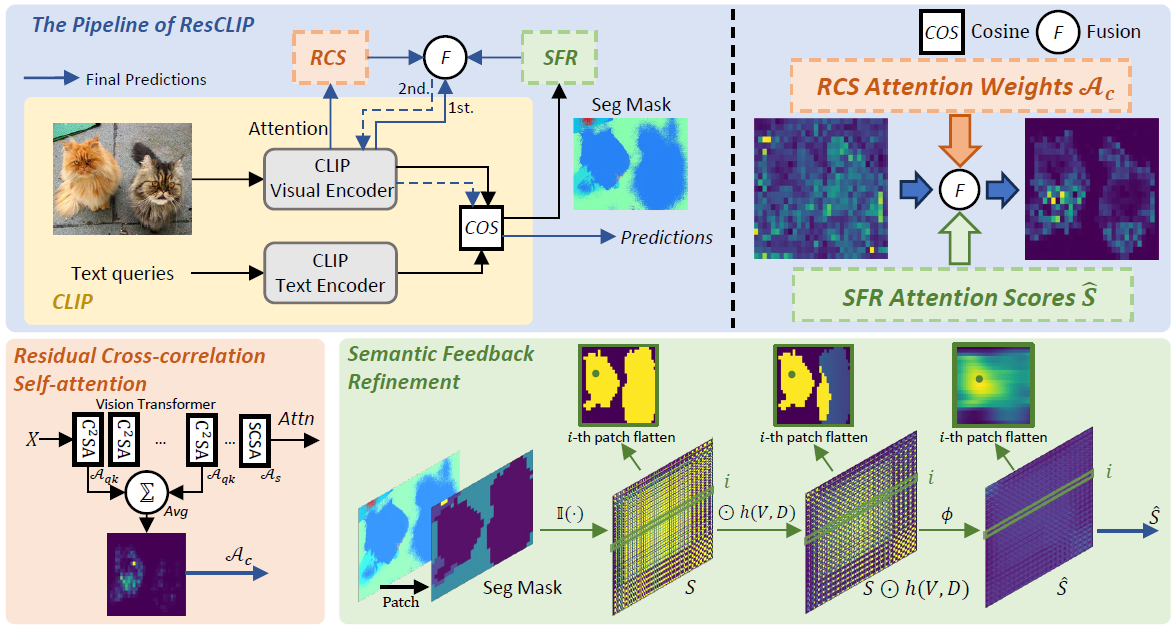

图5 论文《ResCLIP: Residual Attention for Training-free Dense Vision-language Inference》内容示意图

2023级硕士生杨宇航、2021级博士生邓金红以共同第一作者撰写的论文《ResCLIP: Residual Attention for Training-free Dense Vision-language Inference》(作者:杨宇航、邓金红、李文【通讯作者】、段立新)首次揭示了CLIP中间层中互相关自注意力权重蕴含的类相关空间结构特征,突破了其他研究仅关注最后一层自相关自注意力设计的局限。论文创新性地提出残差融合自注意力模块以有效激活CLIP模型的潜在密集预测能力,同时引入语义反馈优化模块强化对同类语义区域的关注度与局部一致性。该方法即插即用,无需任何参数微调即可释放视觉语言大模型的密集推理潜能,在基准数据集上验证了本文算法的有效性。

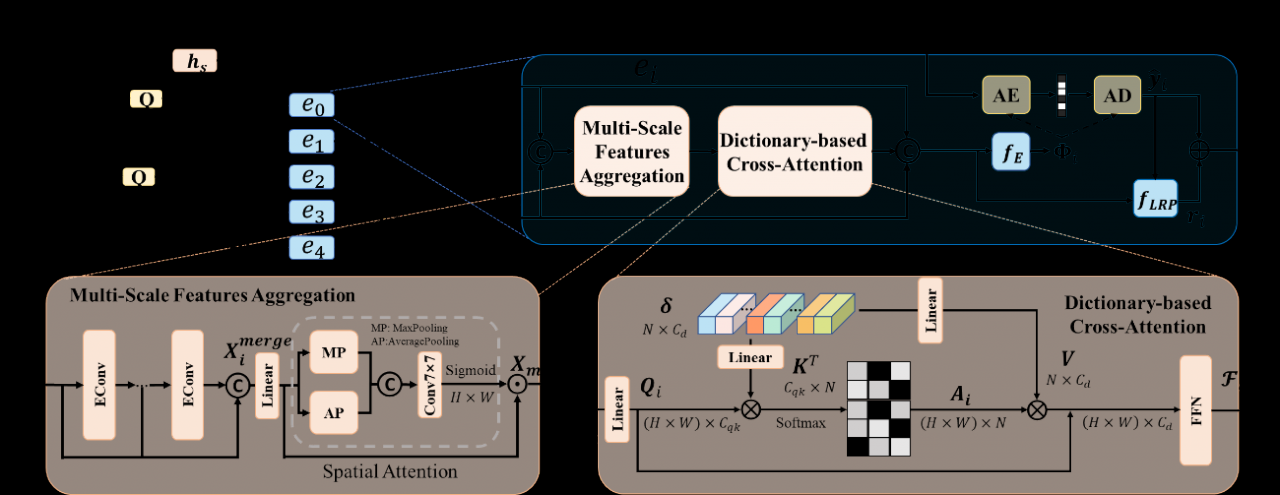

图6 论文《Learned Image Compression with Dictionary-based Entropy Model》熵模型示意图

2023级硕士生卢景博以第一作者撰写的论文《Learned Image Compression with Dictionary-based Entropy Model》(作者:卢景博、张乐恒、周星宇、李穆、李文、顾舒航【通讯作者】)。本文提出了一种高效的基于字典学习的熵模型,该熵模型首先使用字典存储自然图像中常出现的结构、纹理,然后在对图像进行熵编码的过程中通过使用包含部分信息的特征查找包含完整信息的字典,从而可以精准的对图像分布进行建模,完成更高效的图像压缩效果。实验结果表明,该方法同时在编解码延时和率失真权衡上取得了最先进的性能。

计算机(网安)学院数据智能团队(Data Intelligence Group)主要研究领域为机器学习和计算机视觉,具体包括迁移学习、深度学习、弱监督学习、强化学习及在图像视频分析、目标检测、语义分割、眼底影像分析等计算机视觉任务中的应用。研究团队现有正高级教授5人,副教授1人,助理研究员1人,研究生70余人;科研环境近400平方米,设独立机房,配置高性能服务器,拥有GPU显卡200余张。团队近年研究屡获成绩,发表中国科学院JCR一区或CCF A类期刊会议论文80余篇;荣获四川省科学技术进步奖一等奖,吴文俊人工智能科学技术奖-自然科学奖一等奖等;在国内外多项计算机视觉和人工智能大赛中名列前茅,获2021年CVPR NTIRE移动端视频超分辨比赛全球冠军、2021年“智箭•火眼”人工智能挑战赛相关科目全国冠军、2022年“华为杯”四川省大学生嵌入式设计竞赛全省一等奖等。

编辑:王晓刚 / 审核:李果 / 发布:陈伟