即可将网页分享至朋友圈

近日,信息与通信工程学院武畅副教授指导硕士研究生取得的研究成果《L3former: Enhanced multi-scale shared Transformer with Local Linear Layer for long-term series forecasting》在人工智能领域国际顶级期刊《Information Fusion》上正式发表。该期刊是计算机科学与人工智能领域公认的国际最顶尖期刊,2025年最新影响因子高达15.5(五年影响因子17.9),CiteScore达24.1,为中科院计算机科学一区top期刊。2024级硕士研究生夏玉林为第一作者,导师武畅老师为唯一通讯作者,2024级硕士研究生杨小漫为第三作者,电子科技大学为论文唯一单位。

该论文聚焦于长时序列预测问题,提出了一种新型多尺度Transformer结构L3former,有效解决了传统方法在高复杂度、低效率和多尺度特征融合能力弱等方面的瓶颈。L3former在9个权威公开数据集上显著优于现有最先进方法,平均提升幅度为5.8%-16.7%,同时具备更优的计算效率与资源占用率。

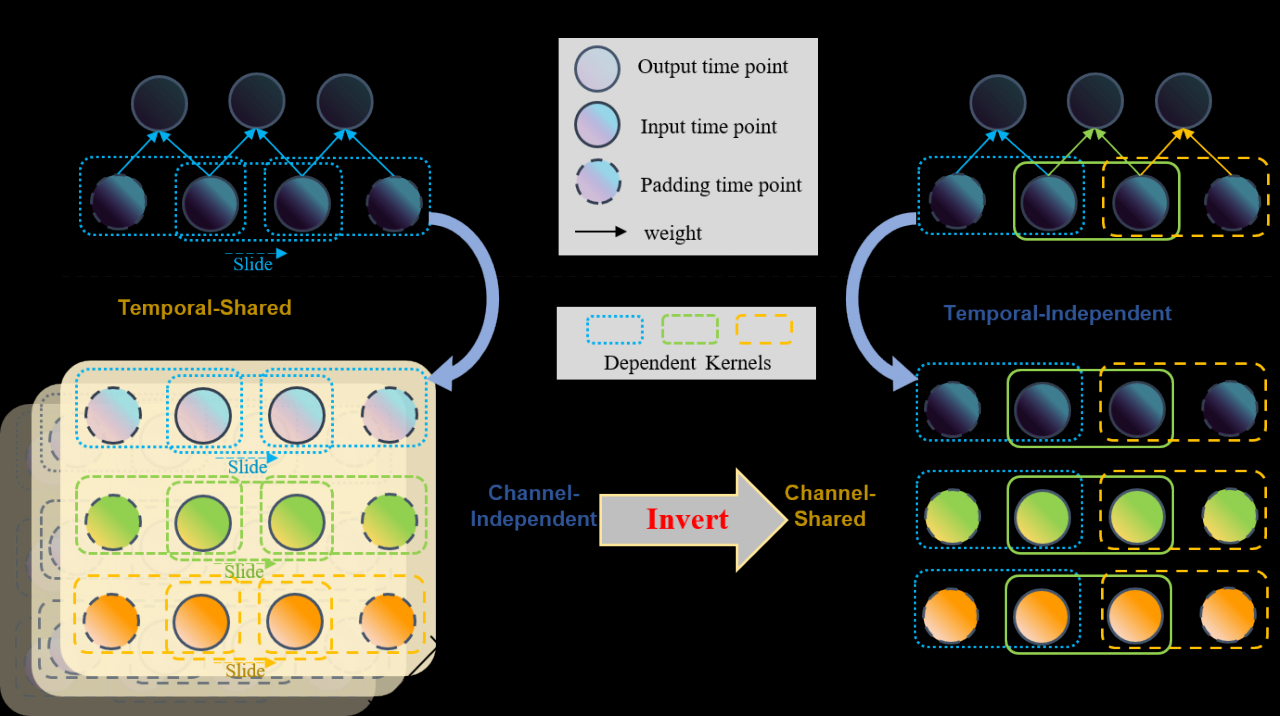

研究的核心创新点是引入了局部线性层(Local Linear Layer, L3)。如图1所示,与传统卷积层相比,L3采用时间维度上的局部线性连接方式,同时在变量维度上共享参数,使模型能够同时捕捉时间局部动态与变量间相关性。这种结构打破了以往网络层的学习范式,在效率和表达力之间取得了平衡,在高维数据集上参数相比卷积减少99.9%以上,计算效率提升1倍,性能与卷积接近。并且如将其集成至其他先进模型,也能带来性能的提升。L3神经网络层有望成为一种新的通用特征提取器。

图1 论文提出的局部线性层和卷积的对比

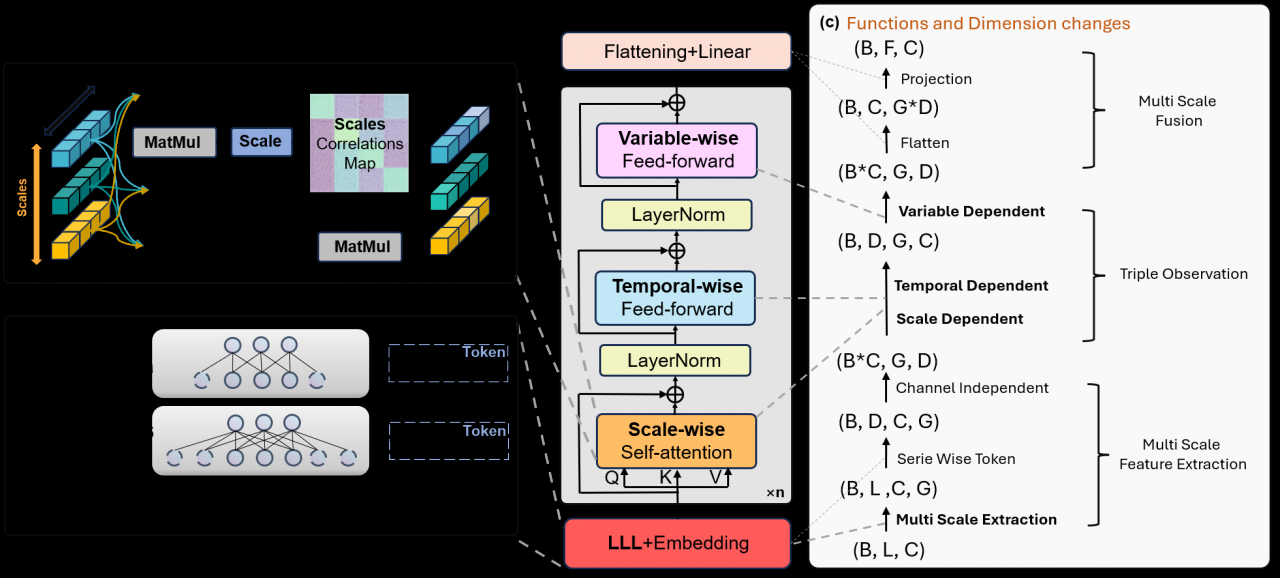

论文还针对多尺度融合和注意力矩阵降维设计了尺度注意力机制尺度自注意机制(Scale-Wise Attention Mechanism, SWAM),如图2所示。由于SWAM关注的是尺度之间的关系,其注意力矩阵维度通常小于6,大大降低了计算复杂度。在处理变量相关性问题上,论文还设计了变量感知前馈层(Variable-Wise Feed-Forward Layer, VWFF),突破了传统通道独立策略在高维数据中性能下降的困境,增强了模型对多变量之间复杂交互的建模能力,在电力、交通和气象等高维预测任务中展现出显著优势。

图2 论文提出的时序模型架构

综上,论文所述模型首次实现了长时预测领域的尺度、时间、变量的三重观测架构,体现了其创新性和实用性。论文不仅在理论上提出了全新的神经网络层设计思路,还通过将L3、SWAM与VWFF模块迁移至其他主流模型,验证了其良好的通用性和可扩展性,为未来时间序列建模提供了新的科学范式。

论文链接:https://authors.elsevier.com/a/1lKY-5a7-G-76f (50天免费全文下载链接)

https://www.sciencedirect.com/science/article/pii/S1566253525004713

编辑:刘瑶 / 审核:李果 / 发布:陈伟